Οι ερευνητές έχουν αναπτύξει μια νέα μέθοδο για την παρακολούθηση των νευρικών σημάτων από τον εγκέφαλο ενός ατόμου με παράλυση και τη μετάφραση τους σε ακουστική ομιλία-όλα σε σχεδόν σε πραγματικό χρόνο. Το αποτέλεσμα είναι ένα σύστημα διασύνδεσης εγκεφάλου-υπολογιστή (BCI) παρόμοιο με μια προηγμένη έκδοση του Google Translate, αλλά αντί να μετατρέψει μια γλώσσα σε μια άλλη, αποκρυπτογραφεί τα νευρωνικά δεδομένα και τα μετατρέπει σε προφορικές προτάσεις.

Οι πρόσφατες εξελίξεις στη μηχανική μάθηση επέτρεψαν στους ερευνητές να εκπαιδεύσουν τους συνθέτες της AI Voice χρησιμοποιώντας ηχογραφήσεις της φωνής του ατόμου, καθιστώντας την παραγόμενη ομιλία πιο φυσική και εξατομικευμένη. Οι ασθενείς με παράλυση έχουν ήδη χρησιμοποιήσει BCI για να βελτιώσουν τη λειτουργία φυσικού ελέγχου κινητήρα από Ελέγχοντας ποντίκια υπολογιστή και προσθετικά άκρα. Αυτό το συγκεκριμένο σύστημα ασχολείται με ένα πιο συγκεκριμένο υποτμήμα ασθενών που έχουν επίσης χάσει την ικανότητά τους να μιλούν. Κατά τη δοκιμή, ο παραλυμένος ασθενής ήταν σε θέση να διαβάσει σιωπηλά τις προτάσεις πλήρους κειμένου, οι οποίες στη συνέχεια μετατράπηκαν σε ομιλία από την φωνή AI με καθυστέρηση μικρότερη από 80 χιλιοστά του δευτερολέπτου.

Τα αποτελέσματα της μελέτης ήταν Δημοσιεύθηκε αυτή την εβδομάδα στο περιοδικό Νευροεπιστήμη της φύσης από μια ομάδα ερευνητών από το Πανεπιστήμιο της Καλιφόρνιας, το Μπέρκλεϊ και το Πανεπιστήμιο της Καλιφόρνιας του Σαν Φρανσίσκο.

“Η προσέγγισή μας streaming φέρνει την ίδια ταχεία ικανότητα αποκωδικοποίησης ομιλίας των συσκευών όπως η Alexa και η Siri σε νευροπροσυσίες”, δήλωσε ο καθηγητής του UC Berkeley και συν-πρωταρχικός ερευνητής της μελέτης Gopala Anumanchipalli σε δήλωση. “Χρησιμοποιώντας έναν παρόμοιο τύπο αλγορίθμου, διαπιστώσαμε ότι θα μπορούσαμε να αποκωδικοποιήσουμε τα νευρικά δεδομένα και, για πρώτη φορά, να επιτρέψουμε τη ροή φωνής κοντά στη συν-συγχρονική φωνή.

Πώς οι ερευνητές ανέλυσαν τα σήματα του εγκεφάλου

Οι ερευνητές συνεργάστηκαν με μια παραλυμένη γυναίκα με την ονομασία Ann, η οποία έχασε την ικανότητά της να μιλήσει μετά από ένα απροσδιόριστο ατύχημα. Για να συλλέξει τα νευρικά δεδομένα, η ομάδα εμφυτεύτηκε μια συστοιχία ηλεκτροκορτικογραφίας υψηλής πυκνότητας 253 καναλιών (ECOG) πάνω από την περιοχή του εγκεφάλου της υπεύθυνη για τον έλεγχο του κινητήρα ομιλίας. Καταγράφηκαν την εγκεφαλική της δραστηριότητα καθώς σιωπηλά έσπευσε ή μιμείται φράσεις που εμφανίζονται σε μια οθόνη. Η Ann παρουσιάστηκε τελικά με εκατοντάδες προτάσεις, όλα με βάση ένα περιορισμένο λεξιλόγιο 1.024 λέξεων. Αυτή η αρχική φάση συλλογής δεδομένων επέτρεψε στους ερευνητές να αρχίσουν να αποκωδικοποιούν τις σκέψεις της.

“Μήπως ουσιαστικά παρεμποδίζουμε τα σήματα όπου η σκέψη μεταφράζεται σε άρθρωση και στη μέση αυτού του ελέγχου του κινητήρα”, δήλωσε ο συν-συγγραφέας Cheol Jun Cho σε δήλωση. “Έτσι, αυτό που αποκωδικοποιούμε μετά από μια σκέψη έχει συμβεί, αφού αποφασίσαμε να πούμε τι να πούμε, αφού αποφασίσαμε ποια λόγια θα χρησιμοποιήσουμε και πώς να μετακινήσουμε τους μυς της φωνητικής προσέγγισης”.

Τα αποκωδικοποιημένα νευρικά δεδομένα στη συνέχεια υποβλήθηκαν σε επεξεργασία μέσω ενός μοντέλου AI με κείμενο σε ομιλία που εκπαιδεύτηκε σε πραγματικές φωνητικές εγγραφές της Ann από πριν από τον τραυματισμό της. Ενώ διάφορα εργαλεία υπήρξαν πολύ καιρό για να βοηθήσουν τα άτομα με παράλυση να επικοινωνούν, είναι συχνά πολύ αργά για φυσική, πίσω και πίσω συνομιλία. Ο καθυστερημένος θεωρητικός φυσικός Stephen Hawking, για παράδειγμα, χρησιμοποίησε έναν υπολογιστή και έναν συνθέτη φωνής για να μιλήσειαλλά η περιορισμένη διεπαφή του συστήματος του επέτρεψε να παράγει μόνο 10 έως 15 λέξεις ανά λεπτό. Τα πιο προηγμένα μοντέλα διεπαφής εγκεφάλου-υπολογιστή (BCI) έχουν βελτιώσει σημαντικά την ταχύτητα επικοινωνίας, αλλά εξακολουθούν να αγωνίζονται με καθυστέρηση εισόδου. Μια προηγούμενη έκδοση αυτού του μοντέλου AI, που αναπτύχθηκε από την ίδια ερευνητική ομάδα, για παράδειγμα, είχε μια μέση καθυστέρηση οκτώ δευτερολέπτων μεταξύ της αποκωδικοποίησης των νευρικών δεδομένων και της παραγωγής ομιλίας.

Συγγενεύων: [This cap is a big step towards universal, noninvasive brain-computer interfaces]

Αυτή η πιο πρόσφατη ανακάλυψη μείωσε την καθυστέρηση εισροών σε λιγότερο από ένα δευτερόλεπτο – μια βελτίωση των ερευνητών αποδίδουν στις ταχείες εξελίξεις στη μηχανική μάθηση σε όλη τη βιομηχανία τεχνολογίας τα τελευταία χρόνια. Σε αντίθεση με τα προηγούμενα μοντέλα, τα οποία περίμεναν την Ann να ολοκληρώσει μια πλήρη σκέψη πριν από τη μετάφραση του, αυτό το σύστημα “συνεχώς αποκωδικοποιεί” την ομιλία ενώ ταυτόχρονα το φωνάζοντας. Για την Ann, αυτό σημαίνει ότι τώρα μπορεί να ακούσει τον εαυτό της να μιλάει μια πρόταση με τη δική της φωνή μέσα σε ένα δευτερόλεπτο που το σκέφτεται.

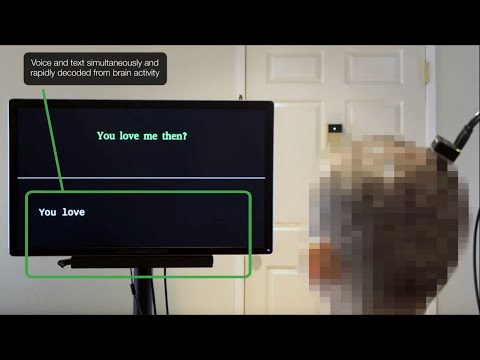

Μια επίδειξη βίντεο της κλινικής δοκιμής δείχνει ότι η Ann εξετάζει τη φράση “You Love Me” σε μια οθόνη μπροστά της. Στιγμές αργότερα, το μοντέλο AI που έχει εκπαιδευτεί με τη δική του φωνή – παραθέτει τις λέξεις δυνατά. Δευτερόλεπτα μετά από αυτό, επαναλαμβάνει με επιτυχία τις φράσεις “έτσι το κάνατε” και “Πού το πήρατε αυτό;” Σύμφωνα με πληροφορίες, η Ann εκτίμησε ότι η συνθετική ομιλία ακουγόταν σαν τη δική της φωνή.

“Ακούγοντας τη δική της φωνή σε σχεδόν πραγματικό χρόνο αύξησε την αίσθηση της ενσάρκωσης”, δήλωσε ο Anumanchipalli.

Οι διεπαφές υπολογιστών εγκεφάλου εγκαταλείπουν το εργαστήριο

Αυτή η πρόοδος έρχεται καθώς οι BCIs κερδίζουν δημόσια αναγνώριση. Το Neuralink, που ιδρύθηκε από τον Elon Musk το 2016, έχει ήδη εμφυτεύσει με επιτυχία τη συσκευή BCI σε τρεις ανθρώπους. Ο πρώτος, ένας 30χρονος άνδρας που ονομάζεται Noland Arbaugh με Quadriplegia, λέει ότι η συσκευή του επέτρεψε να ελέγξει ένα ποντίκι υπολογιστή και να παίξει βιντεοπαιχνίδια χρησιμοποιώντας μόνο τις σκέψεις του. Από τότε, το Neuralink έχει αναβαθμίσει το σύστημα με περισσότερα ηλεκτρόδια, τα οποία η εταιρεία λέει ότι πρέπει να παρέχει μεγαλύτερο εύρος ζώνης και μεγαλύτερη διάρκεια ζωής της μπαταρίας. Ζαχαρωτό Πρόσφατα έλαβε μια ειδική ονομασία Από την Υπηρεσία Τροφίμων και Φαρμάκων (FDA) για να εξερευνήσετε μια παρόμοια συσκευή που στοχεύει στην αποκατάσταση της όρασης. Εν τω μεταξύ, ο Synchron, μια άλλη κορυφαία εταιρεία BCI, έδειξε πρόσφατα ότι ένας ασθενής που ζει με ALS θα μπορούσε Λειτουργήστε ένα Apple Vision Pro Τα ακουστικά μικτής πραγματικότητας χρησιμοποιώντας μόνο νευρικές εισροές.

“Η χρήση αυτού του τύπου βελτιωμένης πραγματικότητας είναι τόσο επιζήμια και μπορώ να φανταστώ ότι θα ήταν για τους άλλους στη θέση μου ή σε άλλους που έχουν χάσει τη δυνατότητα να συμμετάσχουν στην καθημερινή τους ζωή”, ένας ασθενής συγχρονισμού με ALS που ονομάζεται Mark είπε σε δήλωση. “Μπορεί να σας μεταφέρει σε μέρη που ποτέ δεν σκέφτεστε ότι θα δείτε ή θα ζήσετε ξανά.”

Αν και το πεδίο κυριαρχείται κυρίως από τις νεοσύστατες επιχειρήσεις των ΗΠΑ, άλλες χώρες καλύπτουν. Μόλις αυτή την εβδομάδα, μια κινεζική εταιρεία BCI που ονομάζεται Neucyber Neurotech ανακοίνωσε ότι είχε εισαγάγει το δικό της ημι-επεμβατικό τσιπ BCI σε τρεις ασθενείς τον περασμένο μήνα. Η εταιρεία, σύμφωνα με Reutersσχεδιάζει να εμφυτεύσει τη συσκευή “Beinao No.1” σε 10 ακόμη ασθενείς μέχρι το τέλος του έτους.

Όλα αυτά είπαν, θα χρειαστεί ακόμα χρόνος πριν ο BCIS μπορεί να επαναφέρει με νόημα τη συνομιλία διάλογο στην καθημερινή ζωή για όσους δεν έχουν πλέον την ικανότητα ομιλίας. Οι ερευνητές της Καλιφόρνιας λένε ότι τα επόμενα βήματα τους περιλαμβάνουν τη βελτίωση των μεθόδων παρακολούθησης και των μοντέλων AI για να αντικατοπτρίζουν καλύτερα τις αλλαγές στον φωνητικό τόνο και το βήμα, δύο στοιχεία που είναι κρίσιμα για την επικοινωνία των συναισθημάτων. Εργάζονται επίσης για να μειώσουν ακόμη περισσότερο τη χαμηλή τους λανθάνουσα κατάσταση.

“Αυτό συμβαίνει σε εξέλιξη, για να προσπαθήσουμε να δούμε πόσο καλά μπορούμε πραγματικά να αποκωδικοποιήσουμε αυτά τα παραμορφιστικά χαρακτηριστικά από την εγκεφαλική δραστηριότητα”, δήλωσε ο συν-συγγραφέας του UC Berkeley PhD και ο συν-συγγραφέας Kaylo Littlejohn.

VIA: popsci.com